Η πραγματική ακρίβεια ύψους 69% που πέτυχε το Gemini 3 Pro στην αξιολόγηση FACTS αποτελεί το υψηλότερο ποσοστό που κατέγραψε μέχρι σήμερα η GOOGLE σε σύγχρονα AI chatbots. Το στοιχείο αυτό αποτυπώνει με σαφήνεια ένα πρόβλημα που παραμένει: ακόμη και τα πιο προηγμένα μοντέλα τεχνητής νοημοσύνης αποτυγχάνουν να παρέχουν σωστές πληροφορίες σε περίπου μία από τις τρεις απαντήσεις τους, παρά τον πειστικό τρόπο με τον οποίο τις διατυπώνουν.

Η αξιολόγηση πραγματοποιήθηκε μέσω του FACTS Benchmark Suite, ενός νέου πλαισίου δοκιμών που σχεδιάστηκε από την ομάδα FACTS της GOOGLE σε συνεργασία με το Kaggle. Σε αντίθεση με τα περισσότερα benchmarks, τα οποία εξετάζουν κυρίως αν ένα μοντέλο μπορεί να ολοκληρώσει μια εργασία, το FACTS εστιάζει αποκλειστικά στη factual accuracy, δηλαδή στο κατά πόσο οι πληροφορίες που παράγονται είναι αληθείς.

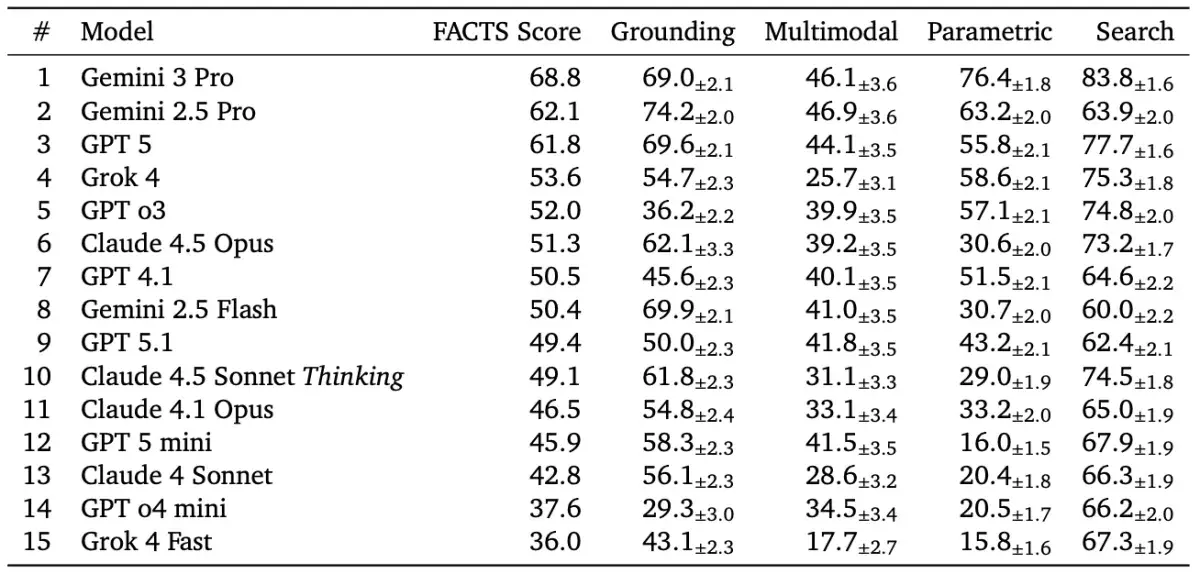

Τα αποτελέσματα καταδεικνύουν σημαντικές αποκλίσεις μεταξύ των κορυφαίων συστημάτων. Πίσω από το Gemini 3 Pro ακολούθησαν το Gemini 2.5 Pro και το ChatGPT-5 της OPENAI, με συνολική ακρίβεια κοντά στο 62%. Χαμηλότερα στην κατάταξη βρέθηκαν το Claude 4.5 Opus της ANTHROPIC, με ποσοστό γύρω στο 51%, και το Grok 4 της XAI, που κατέγραψε περίπου 54%.

Η δομή του benchmark βασίζεται σε τέσσερις διαφορετικούς άξονες πραγματικών χρήσεων. Ο πρώτος αφορά τη parametric knowledge, ελέγχοντας αν τα μοντέλα μπορούν να απαντούν σε ερωτήσεις βασισμένες αποκλειστικά στη γνώση που απέκτησαν κατά την εκπαίδευσή τους. Ο δεύτερος αξιολογεί την απόδοση στην αναζήτηση, εξετάζοντας πόσο αποτελεσματικά χρησιμοποιούνται web εργαλεία για την ανάκτηση σωστών πληροφοριών. Ακολουθεί το grounding, όπου μετράται αν ένα chatbot παραμένει πιστό σε παρεχόμενο έγγραφο χωρίς να προσθέτει ανακριβή στοιχεία. Τέλος, το multimodal understanding εξετάζει την ικανότητα κατανόησης γραφημάτων, διαγραμμάτων και εικόνων.

Ιδιαίτερη ανησυχία προκαλούν οι επιδόσεις στα πολυτροπικά καθήκοντα, όπου τα ποσοστά ακρίβειας συχνά υποχώρησαν κάτω από το 50%. Η αδυναμία αυτή αποκτά βαρύνουσα σημασία σε περιβάλλοντα όπου η λανθασμένη ανάγνωση ενός γραφήματος ή η εσφαλμένη εξαγωγή αριθμών από ένα έγγραφο μπορεί να οδηγήσει σε δύσκολα αναστρέψιμα λάθη.

Για κλάδους όπως τα χρηματοοικονομικά, η υγεία και η νομική, το χάσμα ανάμεσα στη γλωσσική ευχέρεια και την πραγματική ακρίβεια ενέχει ουσιαστικούς κινδύνους. Μια απάντηση που ακούγεται βέβαιη αλλά περιέχει λάθη μπορεί να προκαλέσει σοβαρές επιπτώσεις, ειδικά όταν αντιμετωπίζεται ως αξιόπιστη πηγή γνώσης.

Το συμπέρασμα που προκύπτει από τα δεδομένα της GOOGLE δεν αμφισβητεί τη χρησιμότητα των AI chatbots, αλλά σε κάθε περίπτωση υπογραμμίζει την ανάγκη για επαλήθευση, μηχανισμούς ελέγχου και ανθρώπινη εποπτεία. Παρά τη σταδιακή βελτίωση, η τεχνητή νοημοσύνη δεν μπορεί ακόμη να θεωρηθεί αυτόνομη πηγή αλήθειας.

Στις 25 Φεβρουαρίου το νέο Unpacked της SAMSUNG: Όλα όσα πρέπει να γνωρίζουμε

" loading="lazy" typeof="foaf:Image" class="image-style-thumps">

Στις 25 Φεβρουαρίου το νέο Unpacked της SAMSUNG: Όλα όσα πρέπει να γνωρίζουμε

" loading="lazy" typeof="foaf:Image" class="image-style-thumps">